Cartographier la perception des phonèmes du français

Qu'écoutons-nous vraiment lorsque nous écoutons quelqu'un parler ? Pour répondre à cette question, une équipe de recherche du CNRS a mis en œuvre une méthode expérimentale, appelée image de classification auditive. En analysant les erreurs commises par des individus confrontés à des sons de parole dans un bruit de fond, cette technique a permis de mettre en évidence les éléments acoustiques que les locuteurs et locutrices du français utilisent pour différencier les sons de leur langue. Résultat inattendu : tout le monde ne s'appuie pas sur les mêmes éléments du son de parole pour le comprendre. Cette étude a donné lieu à une publication dans la revue Scientific Reports.

Sans que nous en ayons conscience, notre cerveau accomplit un exploit chaque fois que nous écoutons quelqu'un parler : traduire le son perçu en une série d'unités linguistiques, les phonèmes, tout en faisant abstraction du bruit environnant. Mais sur quelles caractéristiques des sons de parole s’appuie-t-il pour réaliser cette tâche ? Par exemple : quels sont les indices acoustiques qui nous permettent de distinguer les mots bas, tas, pas, gars ou cas, ne différant que par leur phonème initial ? Si cette question semble simple en apparence, il n'existe pourtant à ce jour pas de réponse définitive. Objet de nombreux travaux depuis les années 1920, ce problème a donné naissance à un domaine de recherche à part entière, la phonétique auditive. Ce champ a abouti à des conclusions importantes sur le traitement de la parole par le cerveau humain, néanmoins la question des indices acoustiques sur lesquels l'auditeur ou l'auditrice porte son attention reste toujours en débat.

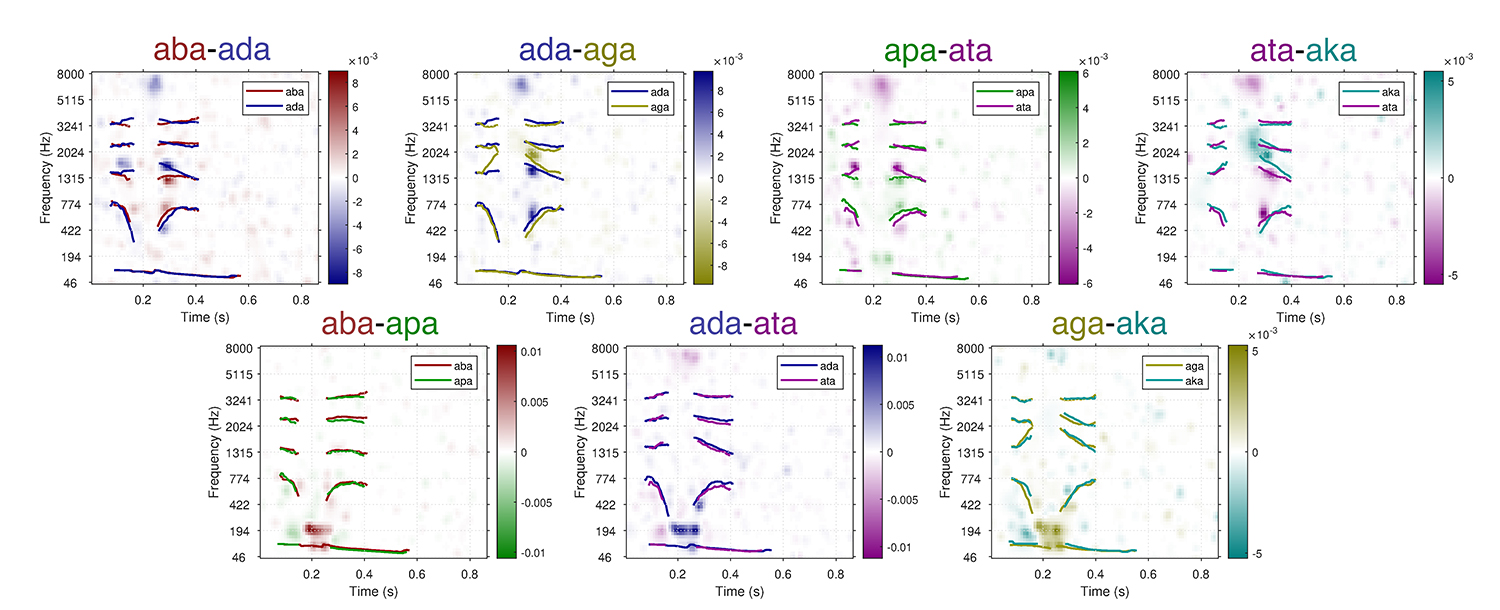

Récemment, des chercheurs du Laboratoire des Systèmes Perceptifs (LSP, UMR8248, CNRS / ENS-PSL) et du Laboratoire de sciences cognitives et psycholinguistique (LSCP, UMR8554, CNRS / EHESS / ENS-PSL) ont exploré cette question à l’aide d’une méthodologie nouvelle : l'image de classification auditive. Cette approche repose sur une idée simple : mettre le cerveau en difficulté pour mieux comprendre son fonctionnement. Cette méthode a été appliquée à l'étude de la perception de six phonèmes particuliers du français, les consonnes occlusives (b, d, g, p, t, et k). Le protocole expérimental consistait à présenter à des participants et participantes francophones qui devaient reconnaître les sons présentés une longue série de sons — aba, ada, aga, apa, ata, et aka — en présence d’un bruit de fond. Leurs erreurs de compréhension ont ensuite fait l’objet d’analyses statistiques permettant d’obtenir une véritable carte temps-fréquence de l'information sonore utilisée par leur cerveau lors de cette tâche. Les résultats indiquent sans ambiguïté que la perception de chacun de ces différents phonèmes repose en réalité sur la détection de multiples caractéristiques des sons, extrêmement fines (d’une durée de quelques centièmes de seconde). Bien que des études antérieures aient déjà démontré théoriquement la multiplicité de ces indices acoustiques, il s’agit ici de la première observation directe de ce phénomène, rendue possible grâce à la résolution très fine de l’image de classification auditive, bien supérieure à celle des méthodes traditionnelles.

Par ailleurs, cette méthode a également mis en lumière un résultat plus inattendu : malgré le fait que tous les participants et participantes de l’étude étaient francophones et sans problèmes d’audition, les cartes temps-fréquence mesurées individuellement présentaient des différences significatives d’une personne à l’autre. Autrement dit : nous n’avons pas tous et toutes exactement la même façon d’écouter les sons de parole, certains individus s’appuyant sur des indices acoustiques que d'autres ne prennent pas en compte. Comprendre l’origine et l’étendue de cette variabilité interindividuelle dans la perception de la parole est essentiel, non seulement sur le plan théorique, mais peut-être également pour expliquer pourquoi certaines personnes malentendantes appareillées ne bénéficient pas autant que d’autres de la correction apportée par leurs aides auditives.

Référence :

Carranante G., Cany,C., Farri P., Giavazzi M., Varnet L. 2024, Mapping the spectrotemporal regions influencing perception of French stop consonants in noise, Sci Rep 14, 27183